19世纪,人们坐在驾驶座上喊着“我们需要更多的石油”,20世纪,人们在电脑屏幕前说着“我们需要更多的硅”,现在,正在与AI对话的人们想着“我们需要更多的算力”。

无论是建立在石油和煤炭之上的现代工业还是基于硅的IT产业,能源永远都是推动生产、经济乃至整个人类社会变革的决定性因素之一。

任何突破性技术都会带来挑战,就像维多利亚时期伦敦上空冒出的黑烟一样,对资源的开采和环境的破坏始终笼罩着我们,为了避免悲剧的重演并促进经济社会更高质量的发展,人们开始用电力、风力替代车里石油和煤炭,用可回收的再生纸替代嘴巴里的塑料吸管,竭尽所能地通过科技减轻对地球负担。

现在,人工智能正如潮水一般席卷全球,其环境足迹已经成为业界正努力解决的问题,而如果将这一问题简化来看那就是:如何让人工智能的自身消耗能源小于其减少碳排放的能力,于是在IT行业我们就可以看到有趣的一幕:

Gartner在其2023年CEO调查报告中表示:“大多数首席执行官(94%)将增加或维持与2022年类似水平的可持续发展和ESG投资。”,而根据戴尔科技集团的研究则发现:目前,76%的IT决策者计划增加预算以支持AI的用例,78%的决策者对人工智能投资如何使其组织受益感到兴奋。

没错,企业同时增加了对可持续发展和能源密集型技术的投资,这一现象看起来似乎相互矛盾,但这并不代表着可持续性和人工智能一定是“非此即彼”的选择,戴尔科技集团认为:技术进步是企业实现其环境和气候目标的先决条件,最好的创新应该在提高技术力的同时支持更加节能和可持续的未来。

人工智能的环境足迹?

从训练到推理

作为第四次工业革命的核心组成部分和驱动力之一的人工智能,在快速推动全球经济和科技向前发展的同时,由其训练和运行以及推理等工作负载所产生的碳足迹也日益凸显出来。

OpenAI曾提出了AI模型性能的“缩放定律”,即在大型神经网络模型中,模型的性能会随着算力、数据规模和参数规模的增加而提升。于是我们就可以看到ChatGPT每一代模型的参数都比上一代多得多:

2019年推出的ChatGPT-2拥有15亿个参数,训练成本为5万美元左右;到了2020年,ChatGPT-3扩大了117倍,来到了1750 亿个参数,训练费用增加了36倍达到了180万美元。

“大就是好”这一极具苏联美学的形容,用在前些年的AI模型上一点都不为过,企业在人工智能领域的比拼,更像是财力与算力规模的比拼。然而,如此庞大的数据规模也代表着巨量的能源消耗。

OpenAI曾发布报告称:自2012年起,用于AI训练的电力每3到4个月就会翻一番。同时也有其他研究报告显示:使用1750亿个参数训练ChatGPT-3消耗了1287兆瓦时的电力,并导致了502吨碳的碳排放,这相当于112辆燃油车行驶一年的碳排放量。

AI所产生的能源消耗不是一次性的,在部署模型之后的推理(AI对新数据进行预测并响应查询的模式)可能会比训练消耗更多的能源。

谷歌估计用于训练和推理人工智能的能源中有40%用于训练,60%用于推理,而卡罗拉多大学与德克萨斯大学的研究人员在一篇《让 AI 更节水》的预印论文中估算了训练 AI的用水,数据显示:ChatGPT每与用户交流25-50个问题,就会消耗掉500毫升的水用于降温,这看起来不算很多,但请不要忘了这样的推理会多次使用来为数百万乃至数亿用户提供服务。

人工智能/可持续

让二者兼而有之

尽管我们前面提到了很多关于人工智能的能源消耗数据,但人工智能的总体碳足迹依然是难以量化和测量的。不过我们都清楚,人工智能的碳足迹始于计算机和数据中心。

而为了管理甚至抵消人工智能不断增长的碳足迹,加强对数据中心能源消耗的控制成为中和人工智能和可持续发展目标的首要任务。IDC也表示:IT决策者在IT规划和采购方面的首要可持续发展优先事项是降低数据中心能耗。

明智且可持续的技术投资可以减少人工智能对环境的影响,同时也使我们能够利用人工智能来解决世界上的挑战,因此,戴尔科技集团正在通过各种各样的技术来降低数据中心能耗。

01、使用节能、可持续的技术

通过现代的、更节能的服务器和存储设备以及对环境负责的冷却方法,最大限度地减少人工智能的碳足迹,同时为数据中心提供可再生能源,是从根源上减少人工智能碳排放及能源消耗的方法之一。

因此,戴尔科技集团在新一代PowerEdge服务器中引入了Dell Smart Flow(智能冷却技术)来保证服务器始终处于最佳效能和功耗区间内,并在服务器设计上加入智能流量配置,带来更大的进气容量使机器内气流更加均衡的分布,以实现可靠、高效的冷却方式。

随着AI引爆服务器市场,液冷服务器的需求也越来越高。在这方面,戴尔科技也拥有丰富的实践经验,已在世界各地的多个数据中心成功部署了浸没式液冷方案;而在中国,戴尔科技集团帮助武汉某高校的超算数据中心通过浸没式液冷技术实现了1.049的超低PUE。

除此以外,戴尔科技现在还推出了第三代DLC(直接液冷)服务器平台及其预集成方案,以消除正确选择和安装液冷相关的复杂性和风险。而凭借顶部箱内的第四代Intel? Xeon CPU内置加速器所带来的性能和节能上的提升,DLC冷却方案不仅能够轻松满足AI工作负载的需求,还可捕获超过22kW的CPU功率。

02、优化工作负载规模

提升数据中心经济性

尽管规模依然是人工智能的决定性因素,但并非所有企业都需要像ChatGPT或PaLM那样庞大的算力集群。科学地调整计算需求和基础设施规模也是实现降低能耗的有效途径。

因此,越来越多的企业开始选择灵活的“即服务”支出模式,以帮助企业节省数据中心成本,科学管理工作负载规模。Forrester的报告指出:超过一半的企业已经采用了IaaS模式,并认为其作为一种服务模式将提供明显的可持续发展优势。

Dell APEX FOD就是一款基于结果的“即服务”产品,通过将硬件交付到客户指定的数据中心、边缘或托管设施,用户只需为实际使用容量付费,可将浪费性过度配置的成本降低多达45%,在获得经济性和可扩展性的同时减少排放和电子垃圾。

03、应用人工智能来提高能源效率

在数据中心长期的运营过程中,使用人工智能跟踪和分析数据,以改进监控和工作负载分配,有助于优化效率、调整工作负载规模并降低能源成本。

戴尔科技集团针对可持续方面的考量不仅仅局限于硬件层面,CloudIQ是戴尔科技推出的基础设施主动监控和预测分析的AIOps应用程序,能够帮助企业优化工作负载整合、减少占用空间,从而做出最佳的可持续发展决策。

鉴于数据中心和人工智能工作负载难以量化碳排放等指标,CloudIQ提供了碳排放检测功能,这一计算标准基于国际能源署(IEA)为每个国家/地区提供的特定位置排放因子,以及全球行业平均电力利用效率 (PUE) 值而构建。

除了检测功能以外,CloudIQ能够通过机器学习来进行能源使用分析和碳足迹预测,算法会预测系统、工作负载以及企业总能源使用量和排放量等,以便用户可以规划未来并做出相应的计划。

结 语

虽然人工智能需要强大的算力和庞大的能源,但目前它只占全球IT能源消耗的一小部分。而随着越来越多的公司、政府和组织利用人工智能来提高其运营和团队的效率和生产力,这种情况将会发生翻天覆地的变化。

人工智能基础设施的开发可以为更加可持续的运营提供一条道路。因为人工智能并非只造成环境上的破坏,其本身也是解决环境问题的关键所在,所有企业都应致力于实现技术的现代化,并寻求在可持续发展和人工智能间“两者兼而有之”的未来。

猜你喜欢

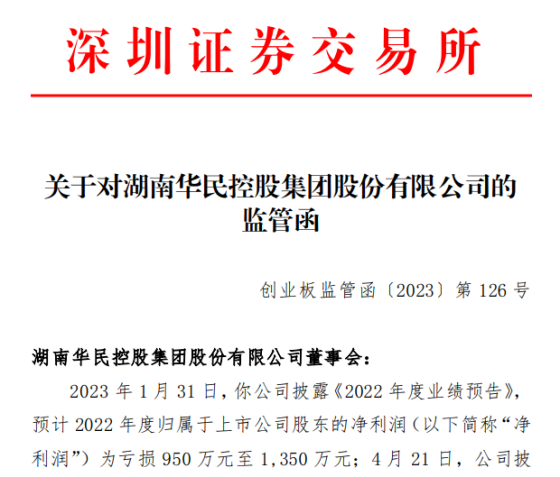

猜你喜欢 因业绩预告披露净利润与实际

因业绩预告披露净利润与实际  第32届中国厨师节在福州举办

第32届中国厨师节在福州举办  生成式AI如何照进新零售?良

生成式AI如何照进新零售?良  水滴保险经纪积极参与“金融

水滴保险经纪积极参与“金融  半导体板块涨3.46% 利扬芯

半导体板块涨3.46% 利扬芯  “点对点”、全程无需接管

“点对点”、全程无需接管  上海自如为毕业生打造舒适住

上海自如为毕业生打造舒适住  国家开放大学首届新商科创新

国家开放大学首届新商科创新